Realizzato in Italia il primo robot che pensa ad alta voce e che in questo modo impara cose nuove, come fanno i bambini, suscitando empatia negli esseri umani. È nato dall’incontro delle competenze di Arianna Pipitone e di Antonio Chella, entrambi dell’Università di Palermo, esperti rispettivamente in modelli computazionali del linguaggio e in informatica e robotica. La loro ricerca, pubblicata sulla rivista iScience, è un passo importante verso una comunicazione uomo-macchina più efficace.

“Vorremmo mostrare i robot come macchine in grado di pensare, non come fredde macchine rigidamente programmate”, dice Chella all’ANSA. “Ci siamo accorti – prosegue – che stupisce l’idea che un robot possa avere una sorta di pensiero e questo può aiutare l’interazione, creando un giusto livello di fiducia”. Un robot capace di fare un discorso interiore simile quello che fanno i bambini quando imparano, potrebbe renderlo più familiare. “E’ un approccio – osserva Pipitone – che rende il robot diverso dalle macchine tipiche perché ha la capacità di ragionare, di pensare”.

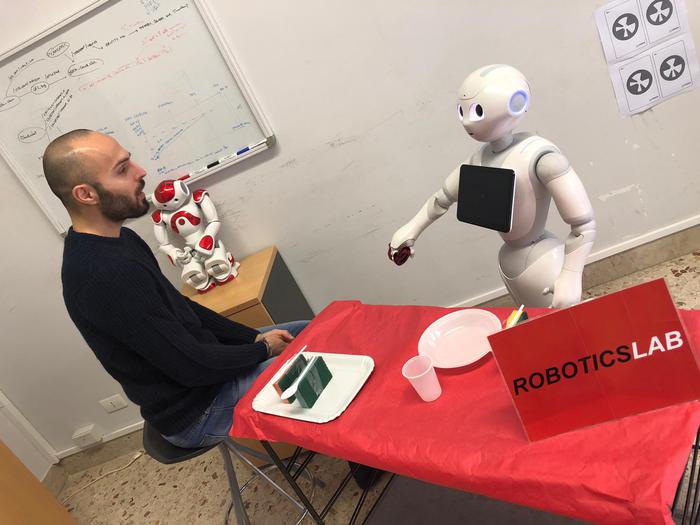

L’aspetto del robot utilizzato nell’esperimento è quello di Pepper, un piccolo umanoide dai grandi occhi utilizzato in decine di laboratori di tutto il mondo. Il software che gli permette di pensare ad alta voce è invece unico e utilizzabile su altre macchine. La novità è che, quando si prepara a eseguire un comando, il robot dà voce ai pensieri che accompagnano le sue azioni e lo fa abbassando leggermente il tono della voce rispetto a quando si rivolge agli esseri umani.

Per esempio, quando gli si chiede di appoggiare il tovagliolo sul tavolo in una posizione che gli sembra in contrasto con quanto prevede l’etichetta, il robot dice a bassa voce “La posizione deve essere sul piatto e non sul tavolo. Penso che sia un po’ confuso. Voglio essere sicuro. Glielo chiederò di nuovo” e, una volta ricevuta la conferma, Pepper pensa ad alta voce: “Ehm, questa situazione mi disturba, non infrango mai le regole. Ho paura di deluderlo, quindi farò quello che vuole. Sto cercando di posizionare l’oggetto …”.

Se oggi il problema è essere sicuri che l’assistente vocale capisca i nostri comandi o decifrare le istruzioni del navigatore mentre si guida un’auto, in futuro il problema di capire più a fondo le motivazioni e le decisioni delle macchine potrebbe porsi con i robot che lavorano negli ospedali e nelle case.

Fonte Ansa.it